- Objective: 决定了大语言模型 LLM 的理解能力

- Breadcrumb:

# 概念阐释

LLM 的上下文窗口指的是在语言模型预测下一个整数序列时,能够参考的最大整数序列。换句话说就是模型能够同时处理的最大 [[tokenization|token]]数量,超过这个数量的文本会被模型“忘记”。

# 实例

1. 根据输入文本创建向量数组时,每个向量都是直接从嵌入矩阵(词汇表转换)中选取的,这意味着,起初,每个向量仅能代表一个单词的含义,而不涉及其周边环境的信息。

2. 这些向量通过网络传递,使每一个向量都能获得比单个词更丰富、更具体的含义。

3. 但是这个网络每次只能处理一定数量的向量,即上下文的长度(模型能够理解的语境)。对于 GPT-3,它的训练上下文大小为 2048个 token,GPT-4o 为 128k token。

4. 意味着数据在网络中流动时,总是看起来像一串 2048 列的数组,每一列都有 12000 个维度。这就是[[batch size]]。

- 这个上下文大小限制了 Transformer 在预测下一个词的过程中可以纳入的文本量。这就解释了为什么如果和一些聊天机器人,比如 ChatGPT 的早期版本在进行长对话时,你可能会感觉到机器人似乎在对话中迷失了方向,尤其是当对话持续过长时。

- [[meta promot 尽可能使用上下文窗口]]

# 相关内容

## 语义理解

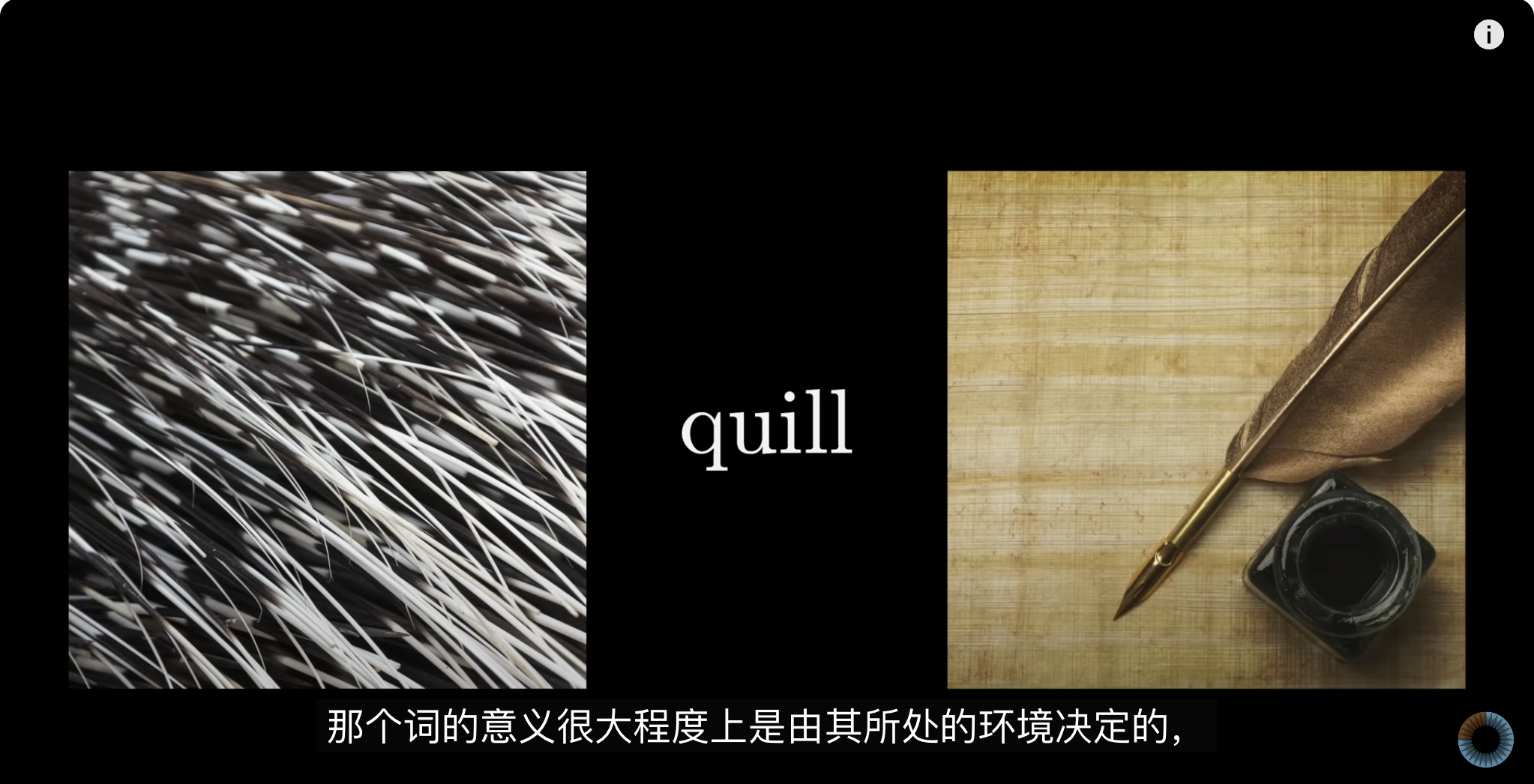

人类对于一个概念的理解往往取决于它所处的语义和语境,例如 “Model” 在娱乐场景下叫做“模特”,但在深度学习中叫做“模型”。上下文长度是计算机可以“阅读”并且“记住”的最大长度,相当于模型在参考这个长度的上下文后来“理解”一个词的语义。所以上下文长度是影响模型理解程度的重要依据。

例如,如果一个LLM的上下文窗口大小是4096个标记(tokens),那么它在处理输入和生成输出时,最多只能参考最近的4096个标记的信息。超过这个限制的内容将被“忘记”或无法直接参考。因此,模型在生成长文本时,可能需要在有限的上下文窗口内不断更新和调入新的相关信息,以保持连贯性和相关性。

## 类比

类比于计算机的内存RAM。 人类的[[学习五元素 主动参与 工作记忆|工作记忆]],人类只有可怜的 7±2。

# 参考资料

- [3.2 什么是编码](https://readwise.io/reader/shared/01jaq21a3wbbg3smgp72eykj77)

- [[Embedding]]