- # why

- # what

- ## 概念

- Model Context Protocol(模型上下文协议,简称MCP)是由Anthropic于2024年11月开源发布的一种开放标准和框架。其目标是在人工智能模型(尤其是大型语言模型,LLM)与外部工具、系统和数据源之间建立统一的上下文连接方式。

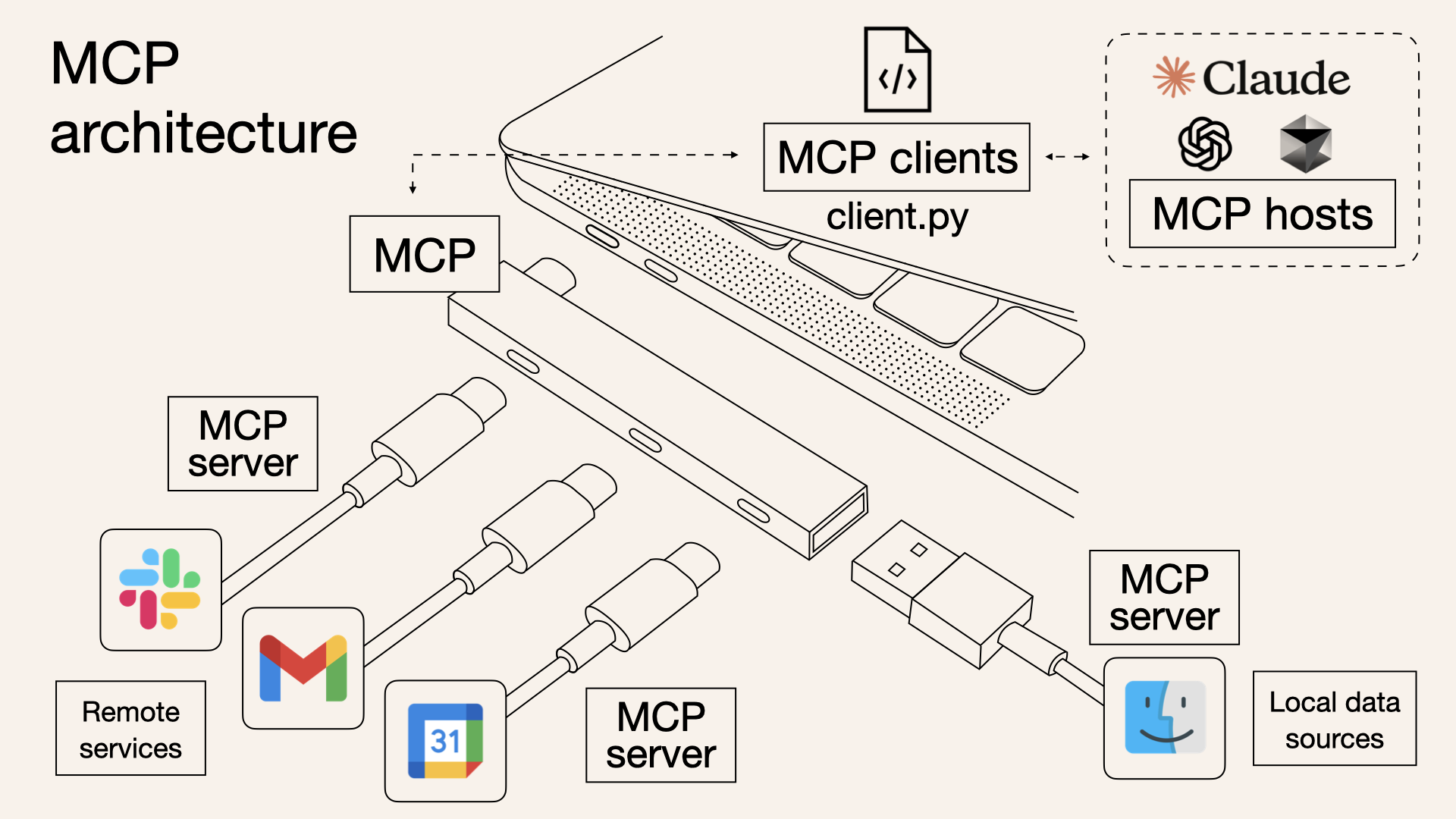

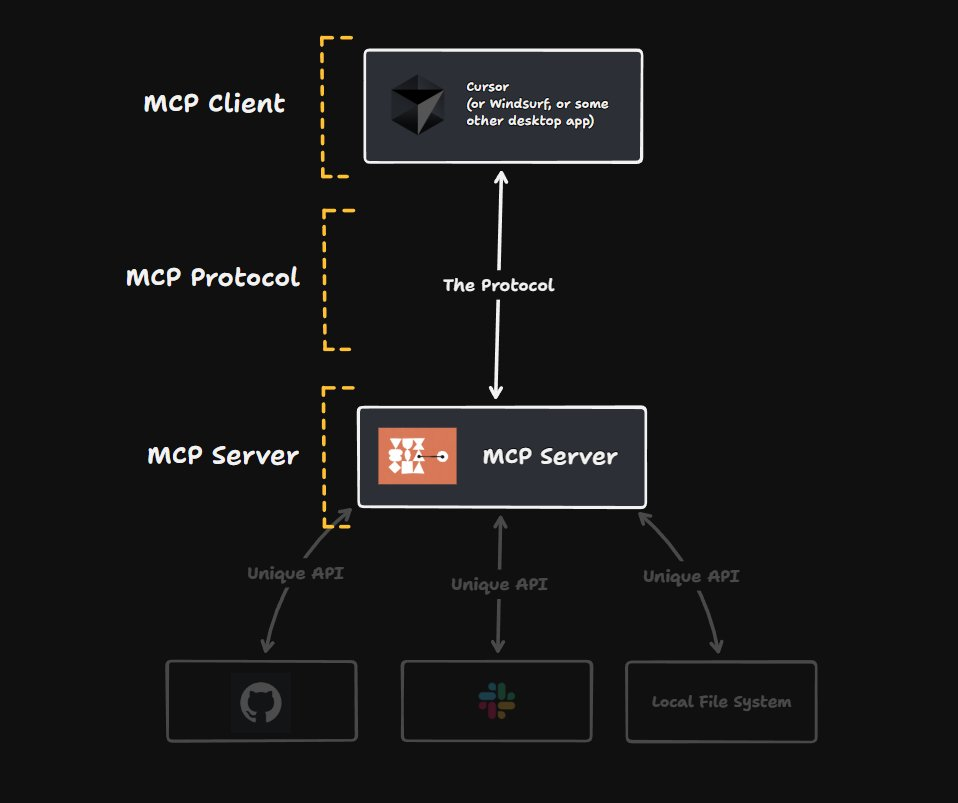

- MCP采用**客户端-服务器**架构,基于**JSON-RPC 2.0**协议进行通信。具体来说,MCP定义了一类**MCP服务器**,由开发者针对某个数据源或应用编写,用以向AI模型暴露可用的功能(称为“工具”)、数据资源以及提示模板等;同时还有对应的 **MCP客户端**,嵌入在AI助手或应用中,与这些服务器建立一对一连接,充当模型与服务器的桥梁 。最终,运行LLM的主机应用(如Claude桌面版、IDE插件或定制AI Agent)可以通过MCP客户端发现并调用各MCP服务器提供的能力,从而让模型以标准化方式访问外部数据和执行操作。

- 在浏览器场景里,MCP 让模型能**看得到**你的页面、**动得了**你的标签页,从而实现“AI 远程驾驶浏览器”。

- 理论上所有的 App,不管是本地的如 logseq、Obsidian,还是远程服务器中的,如 notion、Readwise 、Figma都可以安装** MCP server**,让 App 与 LLM 可以进行对话。

- Anthropic 将其定义为代理系统的 USB-C 端口等效物。它标准化了 AI 应用程序、LLM 和外部数据源(数据库、Gmail、Slack 等)之间的连接。就像[[IO-Link]]。机器是客户端,外围设备是工具,MCP 是 Type-C 接口。因此,无论设备或外围设备由谁制造,它们都能无缝协作。

-

- ## 架构

-

- 完整的 MCP 架构由四部分组成

- **主机 Host** :协调整个系统并管理 LLM 交互

- **客户端 Clients** :以 1:1 关系将主机连接到服务器

- **服务器 Servers** :通过工具、资源和提示提供专门的功能

- **基础协议 Base Protocol** :定义所有这些组件如何通信

- ## 类比

- 早期的 ChatGPT 插件

- # how

- **cursor**

- 例如,在 Cursor 内部,如果遵循协议,您可以连接到任何 MCP 服务器。

- MCP with knowledgebase

- 可以安装本地的ob 里的笔记、Readwise 里的文章、微信读书划线笔记

- vs [[ima 知识库]]:一个是通过 MCP 协议,一个是通过 [[RAG 检索增强生成]]。

- [DR- MCP与 ERP 的可行性](https://readwise.io/reader/shared/01jxwh1qr9936bq1b2jd1cyrgx)

- MCP with [[browser Tool]]

- MCP with figma:不用手动设计了

- [[ChatGPT 连接器]]

- [[claude MCP打通写作工作流]]

- # how good

- # Ref.

- [What is Model Context Protocol (MCP): Explained](https://readwise.io/reader/shared/01jxvtq9sy4p13p650vnjd8tf0)

- [MCP Wikipedia](https://readwise.io/reader/shared/01jxwdc2sv3yrxzc334x62csj6)