- Objective: 语音翻译、Chatbot

- Breadcrumb:

# 概念阐释

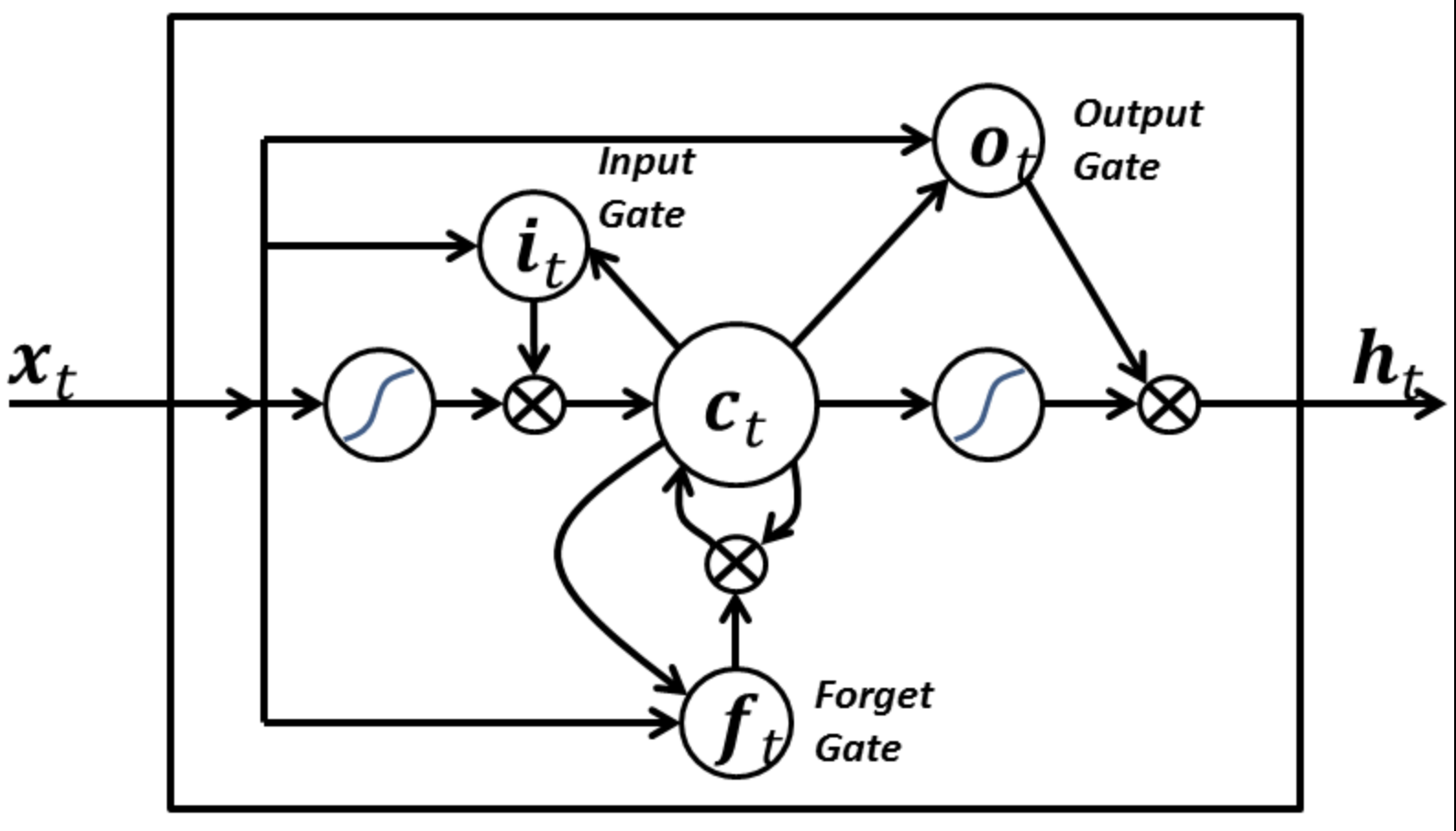

长短期记忆(Long Short-Term Memory, LSTM)由赛普·霍克莱特(Sepp Hochreiter)和尤尔根·施密德胡博(Jürgen Schmidhuber)在 1997 年提出。LSTM是一种[[RNN 循环神经网络]]。在处理**长期依赖关系**上要比 RNN 循环神经网络表现的更好,因为模型中添加了一个叫做内部状态的部分。

- **internal state**:内部状态指的是一个细胞单元 cell,用来存储长期的记忆信息,细胞单元中包含了 3 个部分:

- **forget gate 遗忘门**:在此储存状态中,不相关的内容可以被遗忘,阈值为 0-1;

- **input gate 输入门**:在此储存状态中,添加或更新哪些信息,阈值为 0-1;

- **output gate 输出门**:在此储存状态中,输出哪些信息,阈值为 0-1。

# 实例

- 例如输入一个句子: Martine is buying apples. 此时模型会存储 Martine-male,也许有用,Apples 为复数,也许有用。

- 接着输入第二个句子:Jennifer...此时模型会存储 female,然后忘记“male”这个无用信息。

# 相关内容

## 应用

cell 使得模型在处理更长的上下文关系时表现的更优秀:

- **[[NLP 自然语言处理]]**:在机器翻译、文本生成和语义分析等任务中,LSTM能够捕捉句子或段落中的长距离依赖关系,从而生成更加连贯和语义丰富的文本。

- **时间序列预测**:在金融数据预测、气象预报等任务中,LSTM能够利用长时间跨度的数据趋势进行准确的预测。

- **语音识别**:LSTM可以处理长时间的音频数据,识别出语音中的上下文信息,从而提高语音识别的准确性。

# 参考资料

- [长短期记忆-维基百科](https://zh.wikipedia.org/wiki/長短期記憶)

- [LSTM - IBM](https://readwise.io/reader/shared/01hzvyn1z036bw2c87vnamdxa7)

- [LSTM-GPT](https://chatgpt.com/share/df2c8066-d968-438c-9d2c-3fd82ced6d06)

- 《深度学习》谢诺夫斯基 09