- Objective: ChatGPT根据概率选择下一个词。但是这些概率从何而来?

- Breadcrumb:

# 概念阐释

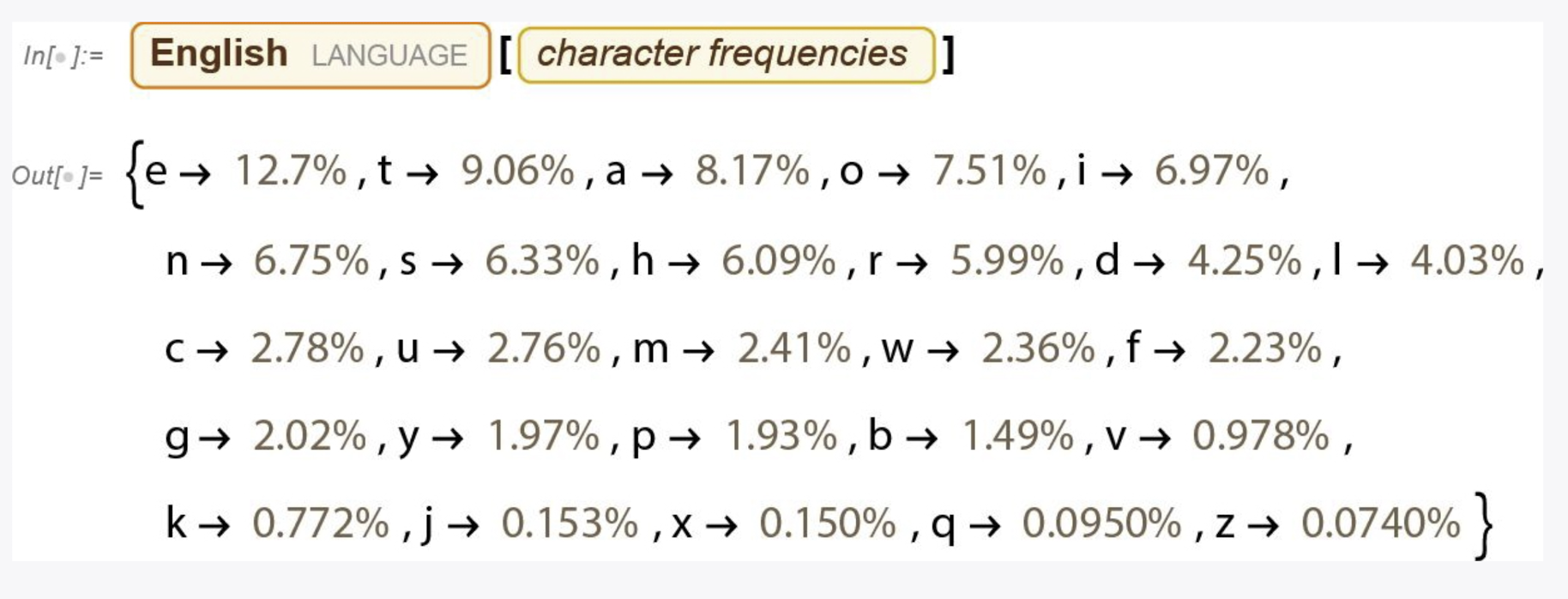

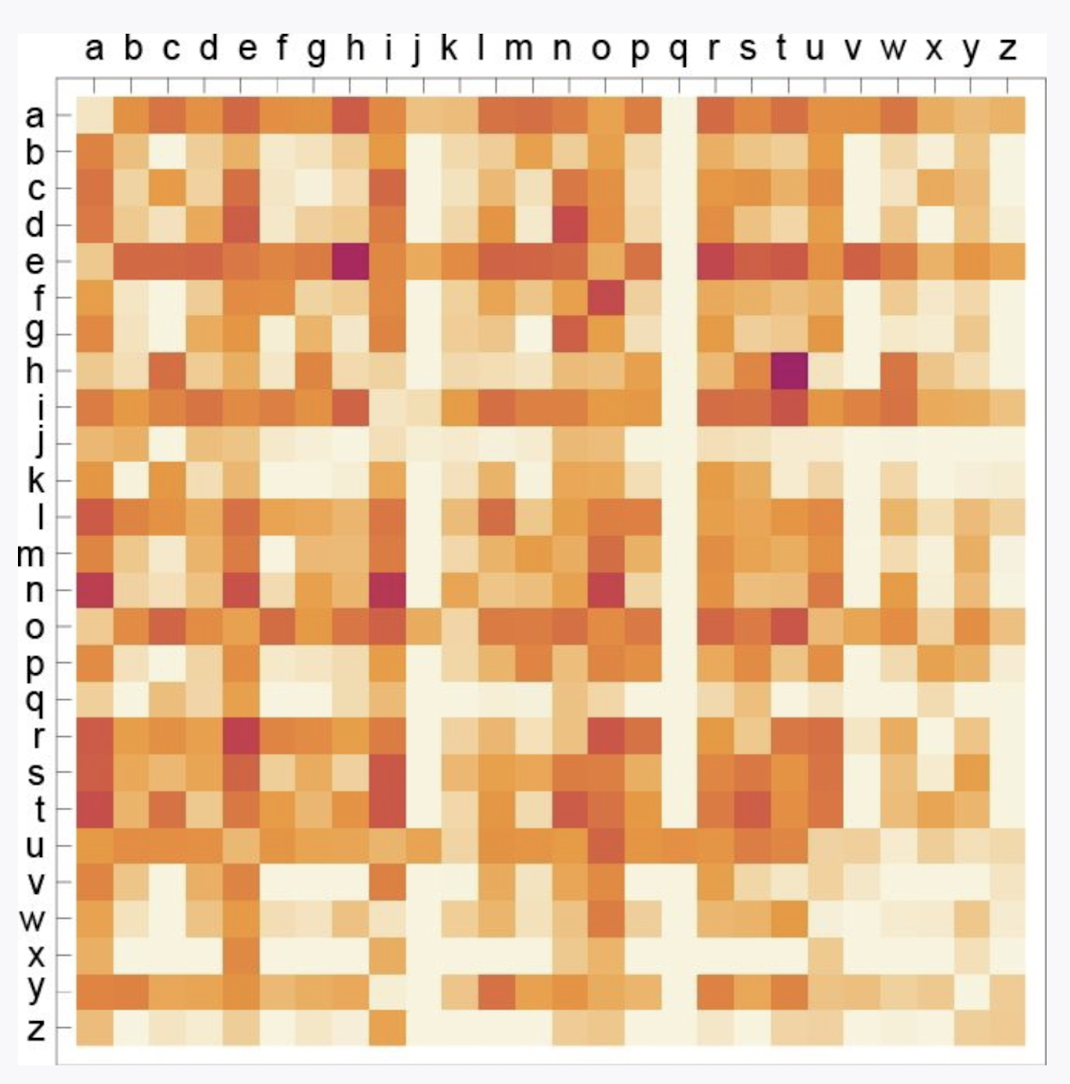

在人类使用的语言中都存在着某些字、字母、词的常用概率。例如英文字母的出现概率、二元字母的出现概率、汉语中的常用词。通过一个简单的测试可以得出一个结论:如果使用逐渐变长的$n$ 元字母的概率生成“随机的词”,就会发现他们它们越来越真实。

但是同样的结论无法用在$n$元词中。英语中有50,000个常用词,我们可以估计出每个词的常用概率,但即使常用词只有4万,一个二元词的数量就有16亿,三元词的数量则会达到60万亿。这个时候的最佳思路是建立一个模型,ChatGPT的核心就是[[LLM 大语言模型]],它能够很好地估计概率。

# 实例

一元字母的概率

二元字母的概率,例如q后面一定是u,其他组合出现的概率为零。

# 相关内容

# 参考资料

- 《这就是ChatGPT》p10-15