# videos checklist

- [x] seen?

- [x] note-taking? thinking about it?

- [x] share?

# why

- 神经网络是如何学习的?

# what

- 梯度下降

- 神经网络的特定执行方式

- 神经元的隐藏层最终要寻找什么

# how

- [0:00](https://www.youtube.com/watch?v=IHZwWFHWa-w&list=PLZHQObOWTQDNU6R1_67000Dx_ZCJB-3pi&index=2) - Introduction

- [0:30](https://www.youtube.com/watch?v=IHZwWFHWa-w&list=PLZHQObOWTQDNU6R1_67000Dx_ZCJB-3pi&index=2&t=30s) - Recap

- [1:49](https://www.youtube.com/watch?v=IHZwWFHWa-w&list=PLZHQObOWTQDNU6R1_67000Dx_ZCJB-3pi&index=2&t=109s) - Using training data

- 神经网络通过大量的数据进行训练,比如在手写识别这个案例中,经过数据训练的神经网络,可以识别训练数据以外的手写字。不过[[MNIST 数据集]]已经收集了数以万计的手写数字图像,所以基本不会有训练数据外的数据了。

- [3:01](https://www.youtube.com/watch?v=IHZwWFHWa-w&list=PLZHQObOWTQDNU6R1_67000Dx_ZCJB-3pi&index=2&t=181s) - Cost functions

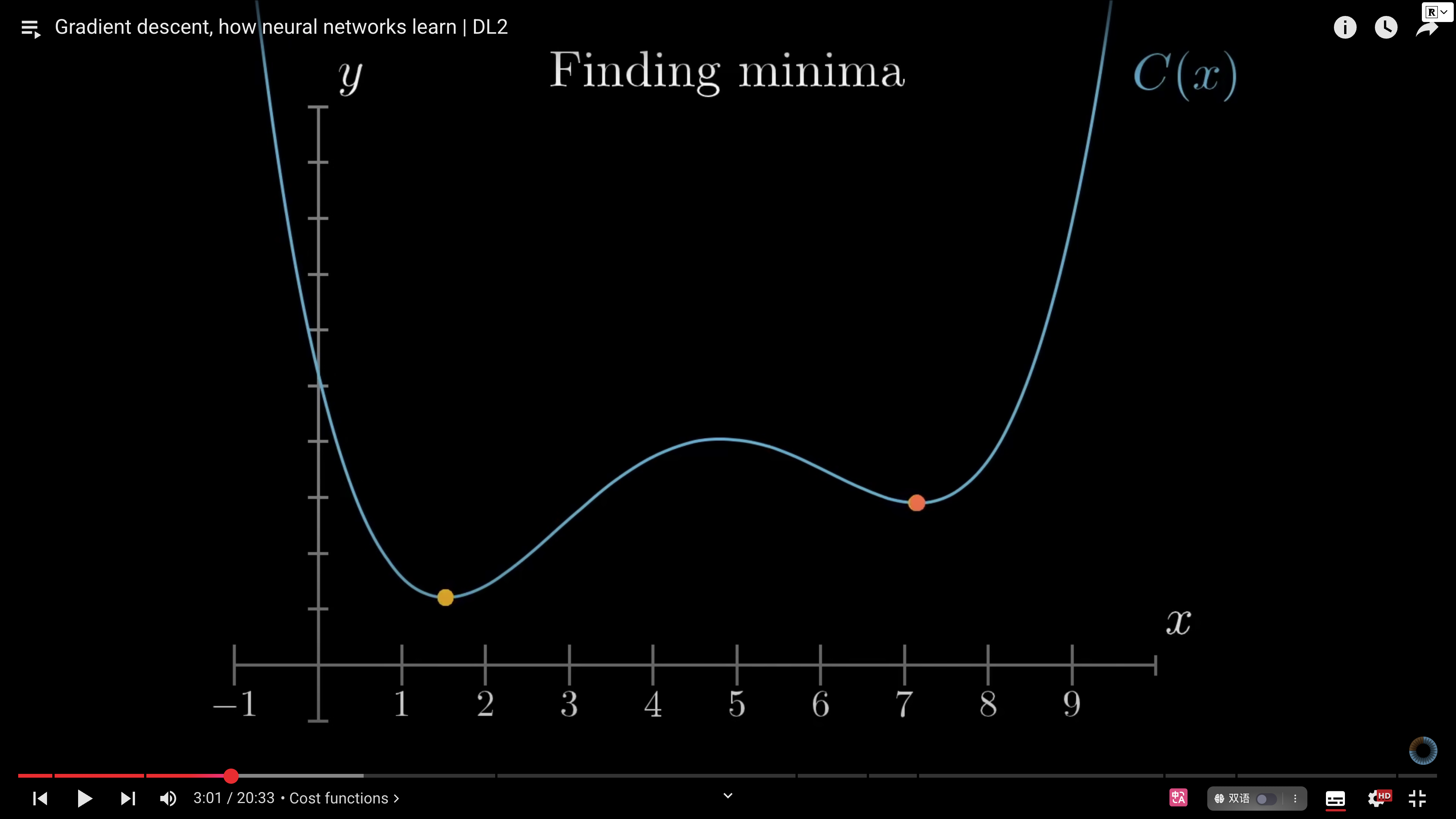

- 找到某个函数的最小值

-

- [[成本函数]][[Loss function 损失函数]]

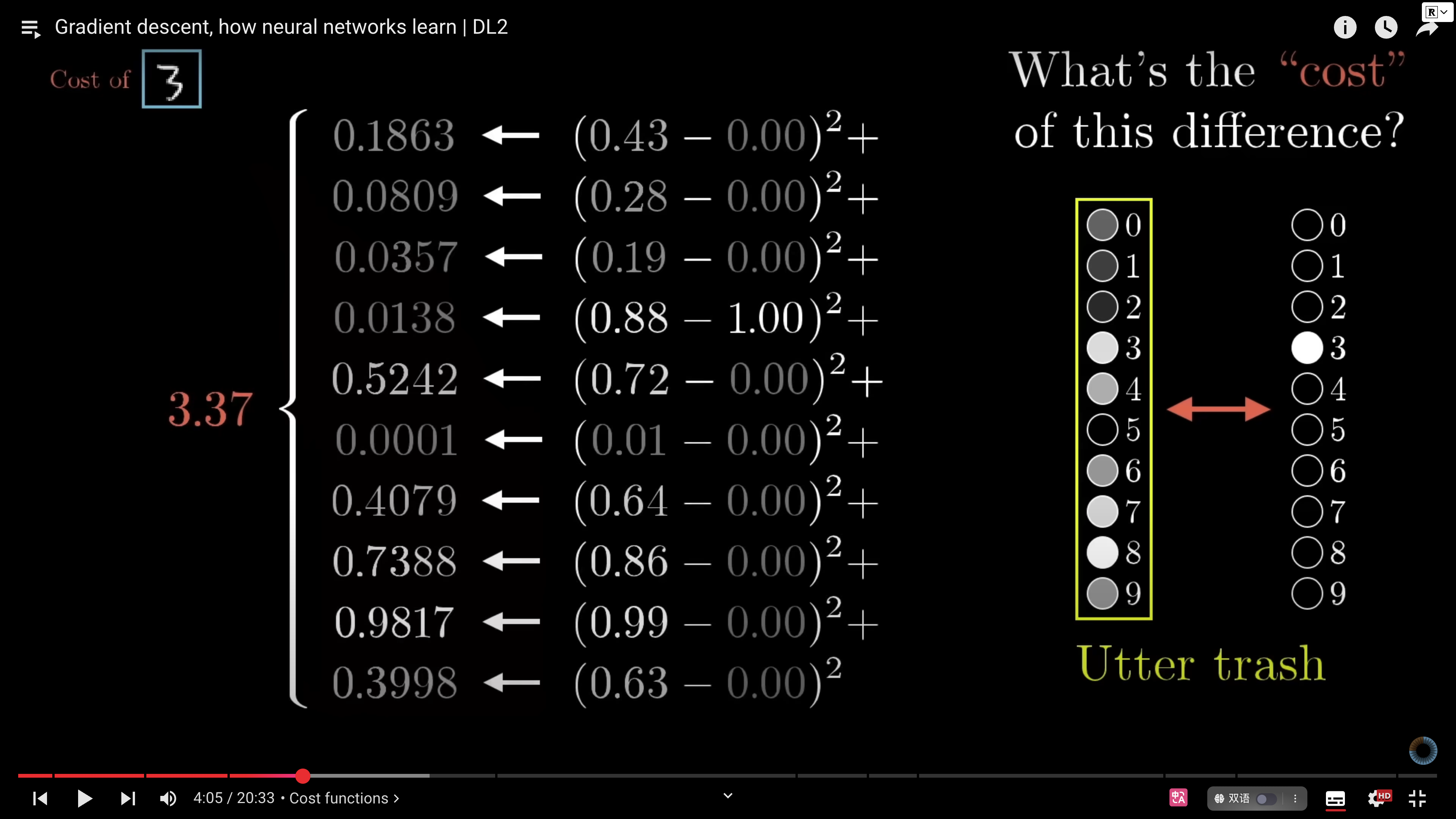

- 模型在训练时,初始状态的权重和偏差都是随机的,所以输出结果也是随机的。此时,你可以定义一个成本函数来告诉计算机,“这个输出对于其他神经元应该是不激活状态 0,但对于这个神经元应该是激活状态 1,但是你给我的是其他的垃圾”。

- 用数学公式来表达$\text{MSE} = \frac{1}{n}\sum_{i=1}^{n}(y_i - \hat{y}_i)^2$当能够正确分类时,这个总和是很小的,所以模型训练时唯一可以观测的数据就是“最小化损失函数”(数以万计训练示例的平均成本) 。

-

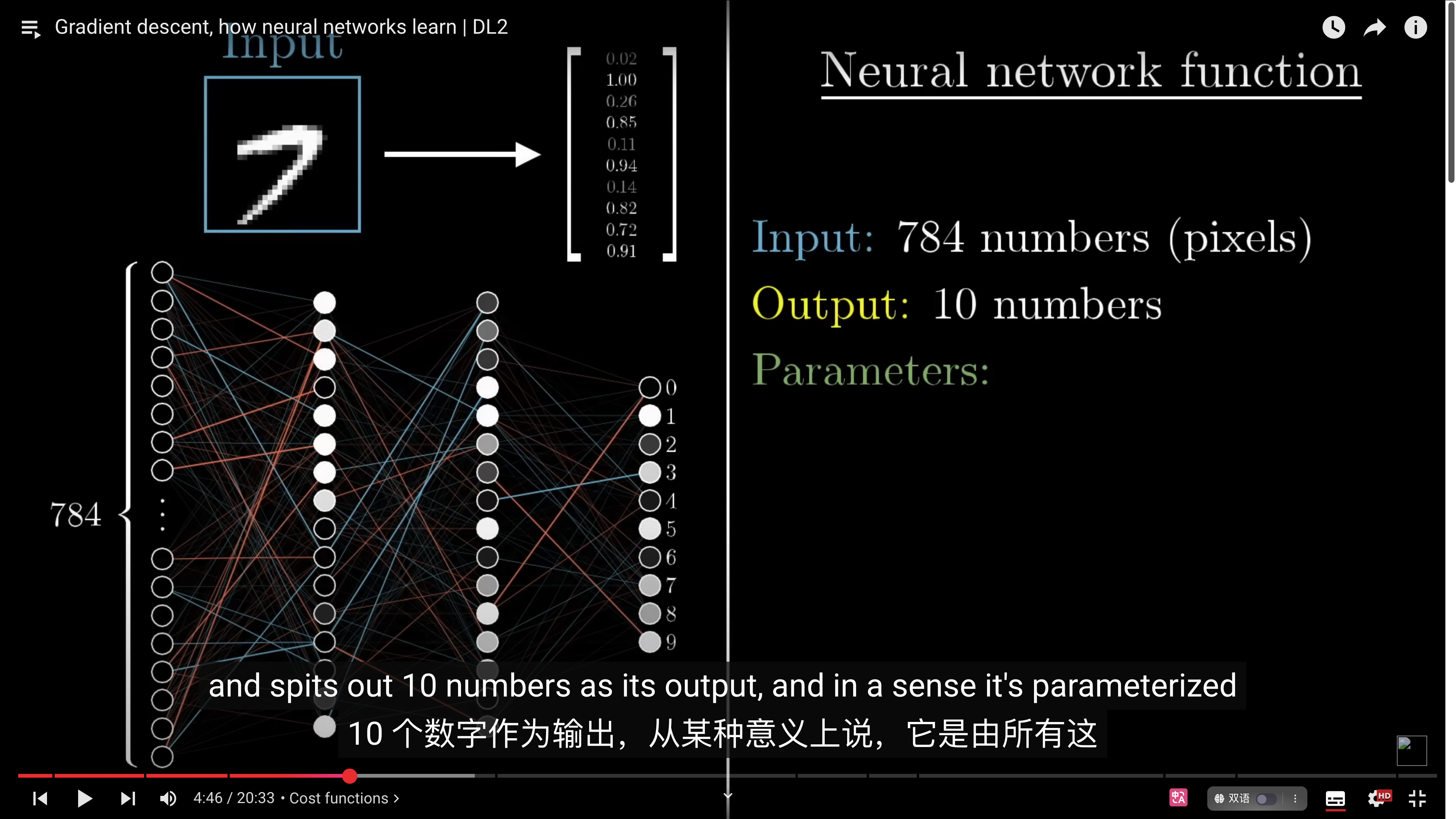

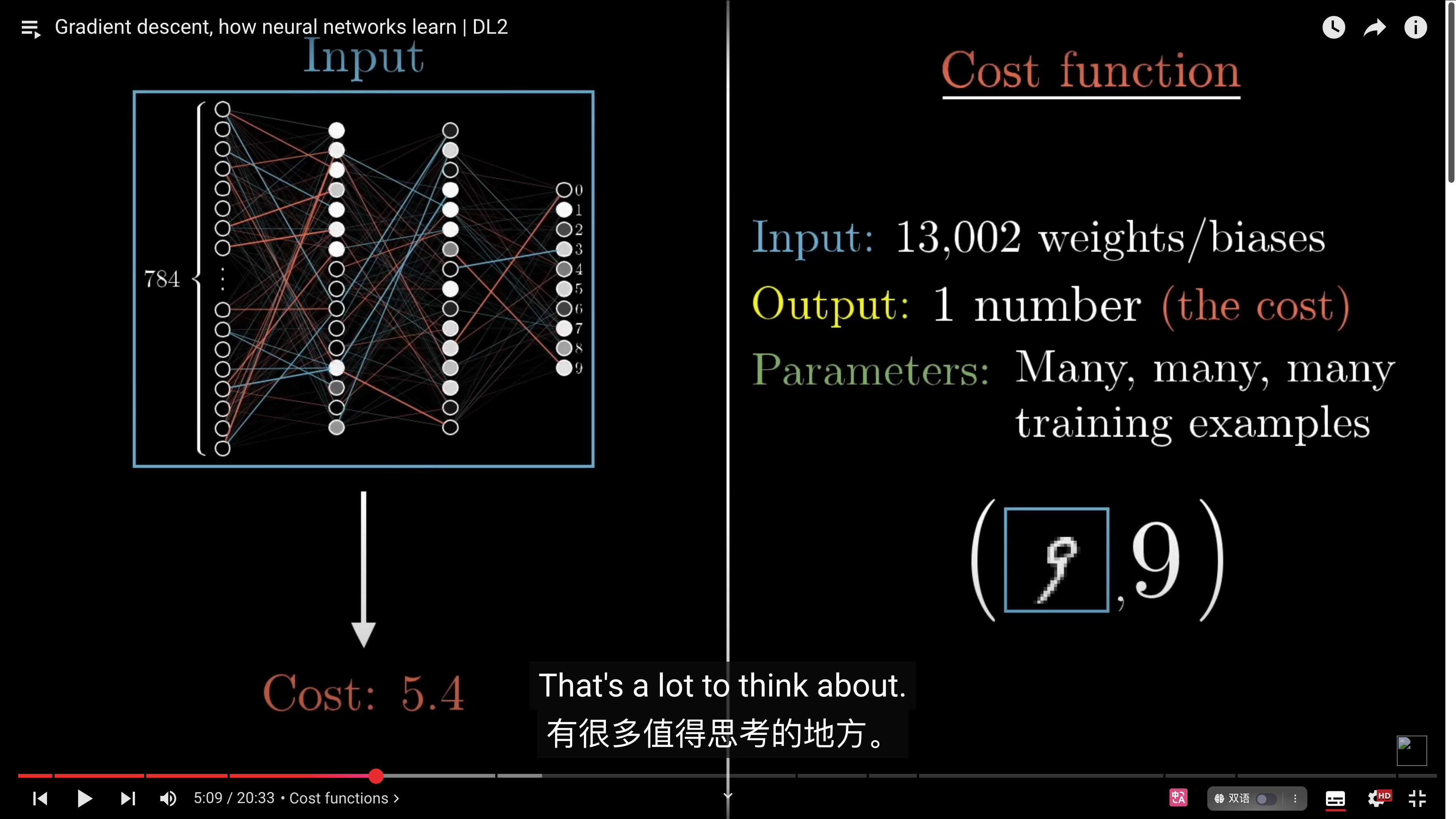

- 成本函数是神经网络函数之上的一种复杂性,神经网络函数

-

- 成本函数是,输入是 13002 个权重,输出是一个数字(成本),这个数字取决于数以万计的训练数据

-

- 只告诉神经网络,你的答案是错的并没有什么帮助,而是告诉它如何能做的更好。

- $C(w_1,w_2,...,w_13002)$

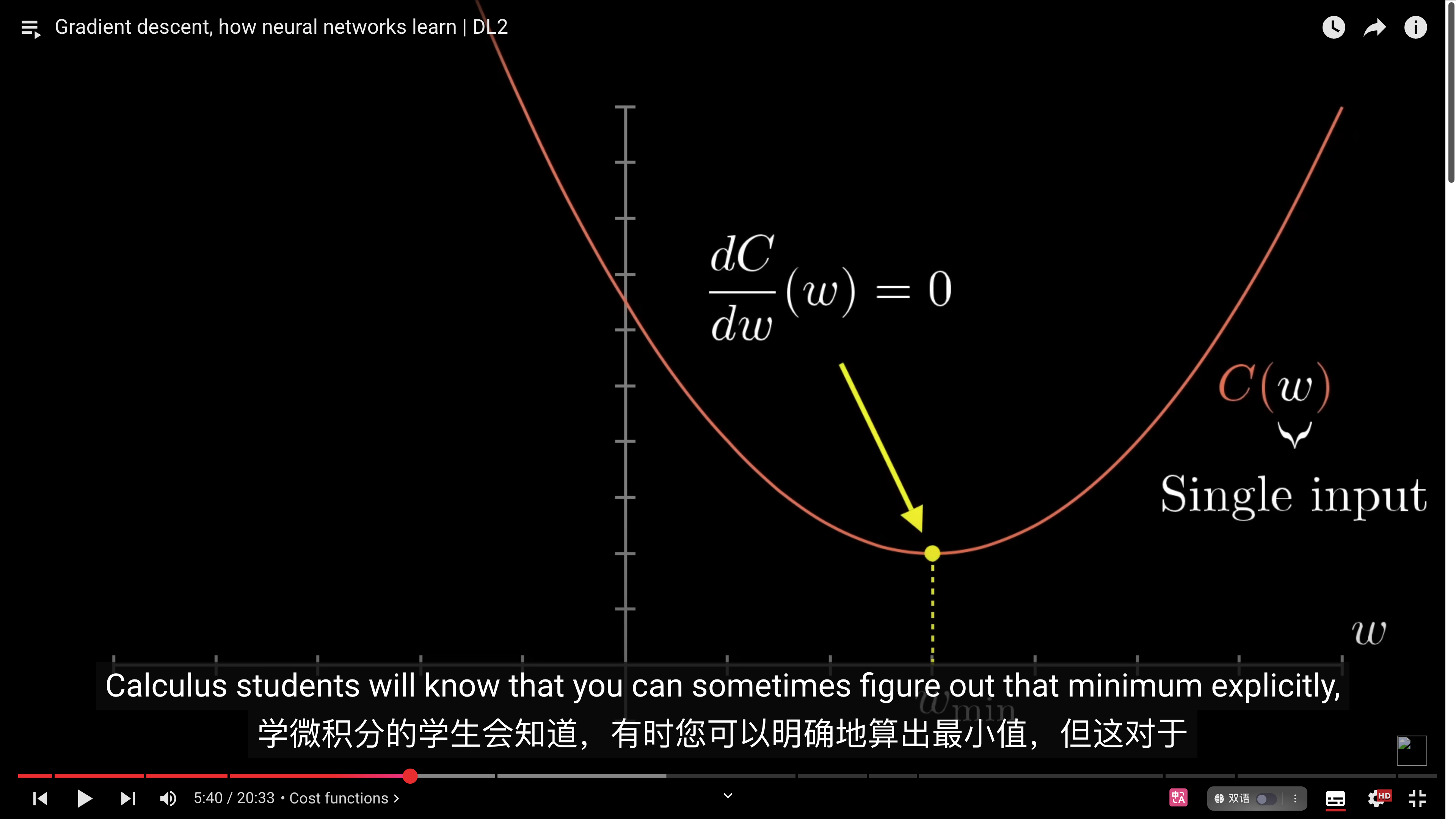

- $C(w)$,只考虑一个函数:一个数为输入,一个数为输出。如何找到该函数的最小化输入?

- 理想化的情况可以通过微积分计算出来 $\frac{dC}{dw}(w)=0$

-

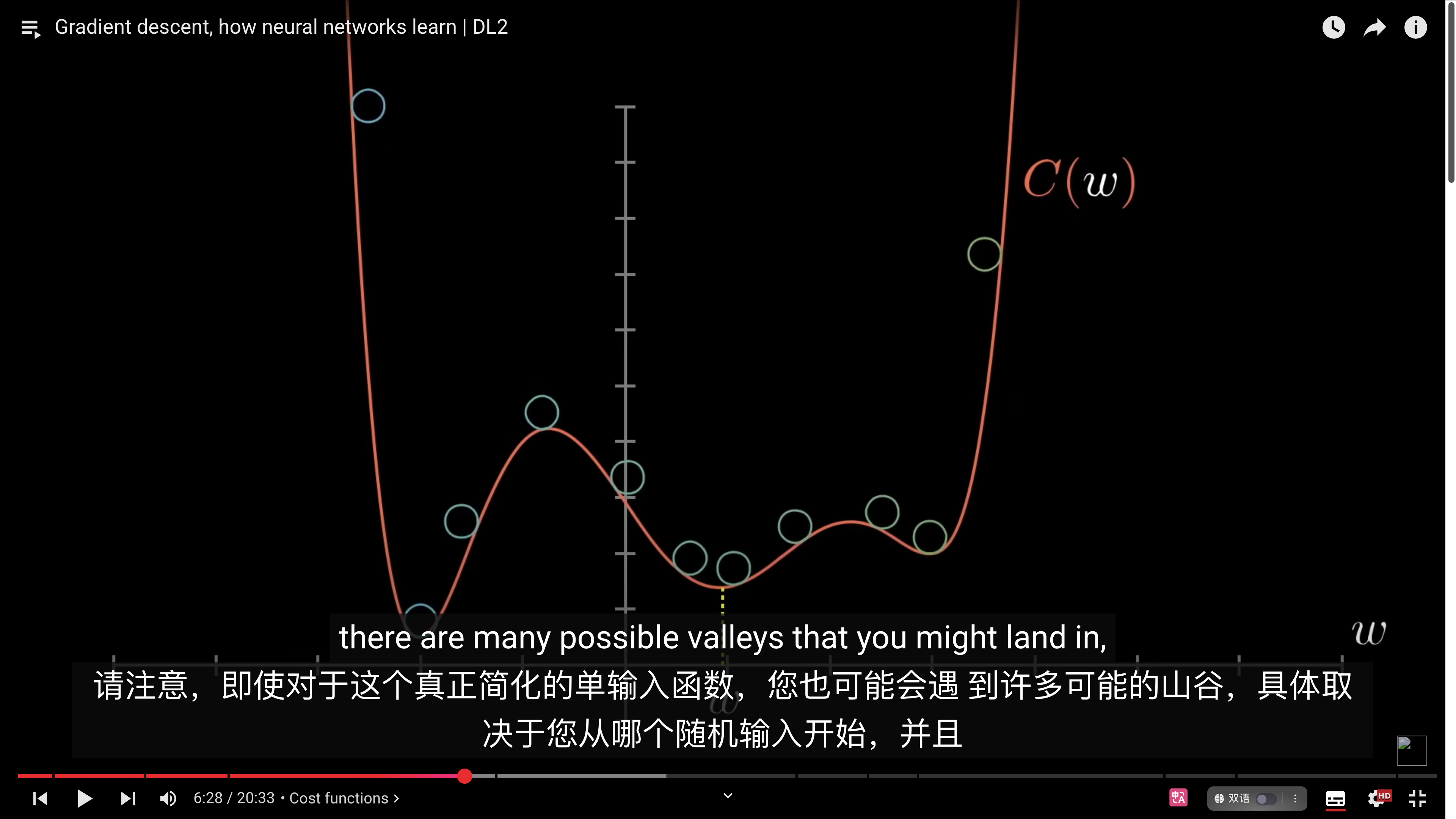

- 但对于神经网络这么复杂的情况显然是不行的,更好的方法是从一个随机的输入开始,然后告诉它向左或是向右来获得最小化输出。**这个最小化的输出可能会遇到不同的最低点,主要取决于随机输入的值是什么。所以不保证输出一定是最小值**

-

- [6:55](https://www.youtube.com/watch?v=IHZwWFHWa-w&list=PLZHQObOWTQDNU6R1_67000Dx_ZCJB-3pi&index=2&t=415s) - Gradient descent

- 如果是一个二维空间,就不是考虑斜率方向了,而是要考虑该往哪个方向走,能够最快降低成本函数?

- 多变量微积分 #todo 在 khan academy上讲过

- 神经网络学习的核心[[Backpropagation 反向传播算法]],下一期讲

- [11:18](https://www.youtube.com/watch?v=IHZwWFHWa-w&list=PLZHQObOWTQDNU6R1_67000Dx_ZCJB-3pi&index=2&t=678s) - More on gradient vectors

- [12:19](https://www.youtube.com/watch?v=IHZwWFHWa-w&list=PLZHQObOWTQDNU6R1_67000Dx_ZCJB-3pi&index=2&t=739s) - Gradient descent recap

- [13:01](https://www.youtube.com/watch?v=IHZwWFHWa-w&list=PLZHQObOWTQDNU6R1_67000Dx_ZCJB-3pi&index=2&t=781s) - Analyzing the network

- [16:37](https://www.youtube.com/watch?v=IHZwWFHWa-w&list=PLZHQObOWTQDNU6R1_67000Dx_ZCJB-3pi&index=2&t=997s) - Learning more

- [17:38](https://www.youtube.com/watch?v=IHZwWFHWa-w&list=PLZHQObOWTQDNU6R1_67000Dx_ZCJB-3pi&index=2&t=1058s) - Lisha Li interview

- [19:58](https://www.youtube.com/watch?v=IHZwWFHWa-w&list=PLZHQObOWTQDNU6R1_67000Dx_ZCJB-3pi&index=2&t=1198s) - Closing thoughts

# how good

# inbox

# todo

# ref.

- 推荐学习资料

- [Neural Networks and Deep Learning](http://neuralnetworksanddeeplearning.com/index.html)

- The book walks through the code behind the example in these videos, which you can find here: [https://github.com/mnielsen/neural-ne...](https://www.youtube.com/redirect?event=video_description&redir_token=QUFFLUhqa3NPc0pyRm4xSGVTU0RzU3JjR1Q0Ni1PazM3QXxBQ3Jtc0tuQ00zZXpiQ1hjeU1Dc1lkRFhoM1IzbTl6ZGpYNG45WmMwb3U3WGdPQUZNREN2WVRUeVRKSGlSWGttWFBFT1N4MkcyN01BLWpkdmhtM1lvOFhBcEJPenpraVNYMjl1bjEtSk8tOTV2ZTF1QlozWkhJcw&q=https%3A%2F%2Fgithub.com%2Fmnielsen%2Fneural-networks-and-deep-learning&v=IHZwWFHWa-w)

- MNIST database: [http://yann.lecun.com/exdb/mnist/](https://www.youtube.com/redirect?event=video_description&redir_token=QUFFLUhqa3R5SVZFRmFNa2txQUJ1RS0yZ0tZSHEwRmdyUXxBQ3Jtc0ttVXA4RGVPbC16TTUzUWNTLWtpU1I2djFhaGtRTnE0TVNTM0xoUG9lYUQ0dFVTRm1adk1xQmhuV3JydnA0M2pCZ25YN0t3NFZrX01HRDkxd1V4N2x5UFp5MGo4dlY1NllNOTZ2Y21HdjBDTC0xOWF5TQ&q=http%3A%2F%2Fyann.lecun.com%2Fexdb%2Fmnist%2F&v=IHZwWFHWa-w)

- Also check out Chris Olah's blog: [http://colah.github.io/](https://www.youtube.com/redirect?event=video_description&redir_token=QUFFLUhqbVVsd1FIc3BScXZoMzJQS3h2LTlKMS16WmNvQXxBQ3Jtc0tsdDZZWHItcVN4V3BmSzJ1RlEza0hpSmkzOFZaY2xmSk1rQjgwUGp2RzFReHZTdXlTcm91bU8td2lON0pxVllUN2pDeVVzMnNkcU9RSEw4SmhkTVZmTHg4dGZTQkZOcHN3OUZoTk5TV01aMEdrOHVFWQ&q=http%3A%2F%2Fcolah.github.io%2F&v=IHZwWFHWa-w) His post on Neural networks and topology is particular beautiful, but honestly all of the stuff there is great.

- And if you like that, you'll love the publications at distill: [https://distill.pub/](https://www.youtube.com/redirect?event=video_description&redir_token=QUFFLUhqbnVqM3JrNkpqdzJ2VWZBbEJRUHhPd1kyakprZ3xBQ3Jtc0ttVkNRREZYZUs0bFlWR0JtYVA3TkFfRmZUc0plYVJmeDI2U3Z5em8tdVFZYXN4ZFU2SFRFOEstelNqTWhVelVwZmtkVGhaMXhjdVctUGZxa28tYlhCSmVXdXVXUnF3cW81TEc1dk9sb01CclJDUzZPUQ&q=https%3A%2F%2Fdistill.pub%2F&v=IHZwWFHWa-w)

- https://www.youtube.com/watch?v=IHZwWFHWa-w&list=PLZHQObOWTQDNU6R1_67000Dx_ZCJB-3pi&t=307s

# related.

# archive.