- 发布时间:2024-05-13

## 性能概览

- **o for omni**,全面的意思,朝着更自然的人类与计算机交互迈出的一步。

- **目标**:更自然的人机交互模型,就是更像人类去处理问题

- **全知的理解**:就像一个陌生人在见到你时能够感受到的一切,从对话到视觉。如果gpt 变成实时在线的状态,那就是 [[《Her》]] 和 JAVAS 成真的时刻了。

- **[[多模态]]**:接受文本、音频、图像作为组合输入,并生成任何文本、音频和图像的组合输出。同时,在多模态理解能力中,最让人感到惊奇的是,它能够识别人类的感情,并根据感情做出“有感情的反应”。

- **几乎无延迟**:它对音频输入的响应时间最短为232毫秒,平均为320毫秒,这与人类在对话中的响应时间相似。

- 可在电脑桌面运行,随时拥有一个AI队友,能随时帮你处理写代码、看图表等任务。

- live video,实时在线的状态, [[《Her》]] 和 JAVAS 成真的时刻了。

- <iframe width="560" height="315" src="https://www.youtube.com/embed/wfAYBdaGVxs?si=5iESE_WfrMiqGwHT" title="YouTube video player" frameborder="0" allow="accelerometer; autoplay; clipboard-write; encrypted-media; gyroscope; picture-in-picture; web-share" referrerpolicy="strict-origin-when-cross-origin" allowfullscreen></iframe>

- [[tokenization]]在一些语言方面也得到了提升。

- 中文减少了 1.4 倍,从 34-24

- 英文减少了 1.1 倍,从 27-24

- 2014-11-20 版本

-

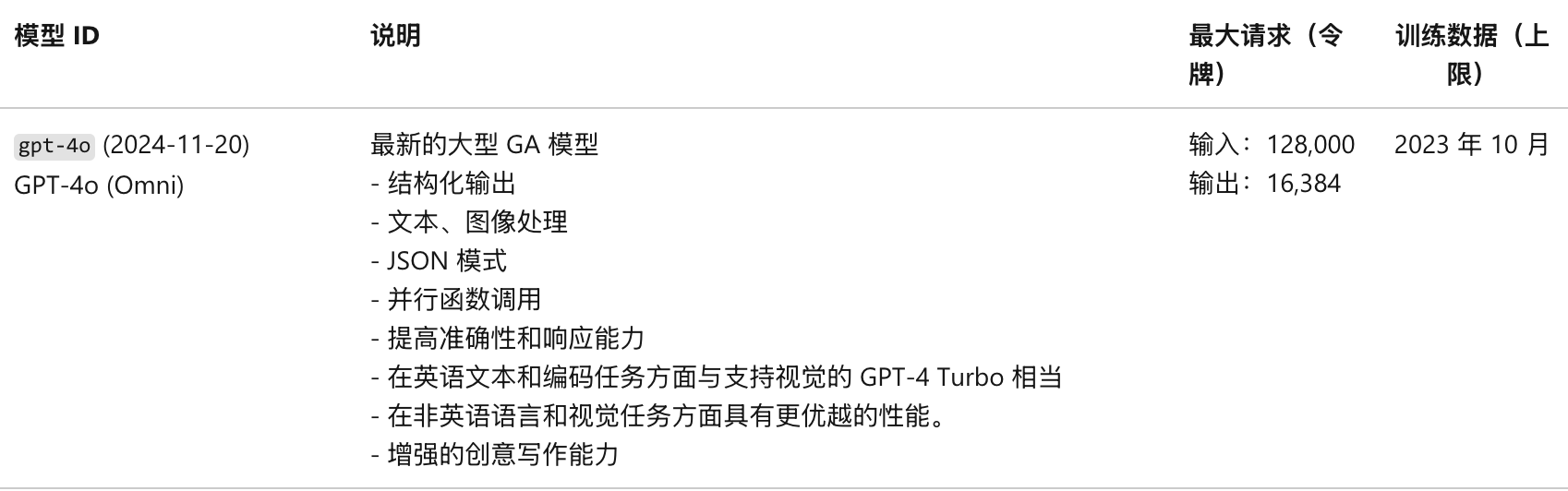

## 模型比较

- 处理文本、代码等推理能力上与 GPT-4 turbo 匹配,速度更快,成本更低。但在处理语音、视觉方面创下了新的记录。

## 功能详解

- GPT-4o是**真正的多模态模型**在视频和音频处理方面更强*:

- **语音模式**:

- GPT-3.5 延迟为 2.8 秒,GPT-4 延迟为 5.4 秒,因为GPT-3.5 和 GPT-4 都是通过模型组合完成的:

- 第一个模型[[whisper]] 将音频转录为文本

- GPT-3.5或 GPT4 接收并输出文本

- 第三个模型[[TTS]]再将文本转换为音频。

- GPT-4丢失了很多信息,不能观察语调,也不能输出笑声和表达情感。

- GPT-4o 是 **单独训练的新模型,可以[[端到端]]的处理文本、视频和音频**,从输入到输出都由一个[[ANN 人工神经网络]]处理。

- 从技术角度来看,OpenAI 已经找到了一种方法,可以将音频直接映射到音频作为一级模态,并将视频实时传输到 transformer。这些需要对 token 化和架构进行一些新的研究,但总体来说是一个数据和系统优化问题(大多数事情都是如此)。

- Google 在 2023 年 12 月发布的 Gemini 模型也是端到端的多模态模型。

- 情感理解:手机版可以通过人类的声音理解人类的状态、情绪。

- **语音翻译**:小语种翻译表现优异。

- 实时对话:端到端的多模态大大缩短了反应时间,达到人类对话的速度。

- 实时语音翻译

- **视觉模式**:OCR(光学字符识别)能力

- 识别人类所处的环境,正在做的事情

- 桌面版GPT-4o可以利用视觉能力识别出屏幕中你在写的代码,看的PDF,并给出总结或者提示。(如何实现?)

- 它能对实时环境产生理解,随时对已经变化的环境做反应,甚至还能借助记忆能力联系起这些变化。这比起过去不停截图给一个软件才能顺利对话的交互模式易用太多了。(如何实现?)

- **因材施教**:另一个工程师在纸上现写的方程,让 ChatGPT 不是直接给答案,而是让它解释要一步步怎么做。看起来,它在教人做题方面很有潜力。ChatGPT 说,每当你为数学焦头烂额的时候,我就在你身边。

- **人情味**:

- > 在Demo过程中,当测试者要求它用“最戏剧性”的方式去讲故事的时候,她表现的和一个话剧演员几乎没什么差别了。这需要她懂得“戏剧性”这一在很大程度上形容情绪强度的词汇是什么意思。

- 属于每个人的云端情人HER到来了。AI交友、AI心理咨询师等等所有需要强情绪交互的赛道都会很快就变成一片蓝海。

- **组合**:可以通过文本、音频、视频进行任意组合输出,这相当于可以 **无限解锁新功能**。

- **其他能力**:

- 3D能力(能够实现图片转换为 3D 模型?参考 OpenAI blog)、图像诗能力、转换卡通照片等能力。3D 视觉内容生成的能力,能够从 6 个生成的图像进行 3D 重建

- 采用全新的[[tokenization|tokenizer 分词处理器]],讲很多小语种的 token 数量减少了数倍,其中包括中文。新的分词器名为「o200k_base」,包含了更多的词汇,从而显著压缩不同语言的 Token 数量。

- 与 GPT-4o 合作,你只需要输入几段文字,就能得到一组连续的漫画分镜

- 文本转艺术字

## 限制

- **阅读长文的能力**:在网页版的 ChatGPT 中进行对话时仍然采用滑动上下文窗口,而非 128k 的模型理论最大上下文窗口。在阅读大型文档时,模型仍然只能获取开头部分内容,后续内容需要模型使用内置工具进行文中搜索获取,阅读长文的体验很有可能与当前不会有较明显差异,甚至可能不如以长上下文窗口著称的 Claude 和国内的 Kimi。

# 参考资料

- 同声翻译功能尝试了一下,不太能做到。GPT-4 可以。

- [x] [GPT-4o深夜炸场!AI实时视频通话丝滑如人类,Plus功能免费可用,奥特曼:《她》来了](https://readwise.io/reader/shared/01hxtbg8wyzwq58xny8hkz3nck)

- [x] [GPT-4o](https://openai.com/index/hello-gpt-4o/)

- [more tools](https://openai.com/index/hello-gpt-4o/)

- [发布页面](https://openai.com/index/spring-update/)

- [x] [OpenAI教谷歌做语音助手!新模型GPT-4o科幻级语音交互,零延迟满情绪,AI进入HER时代](https://readwise.io/reader/shared/01hxt82rqwjwkdn7bdrmbpy622/)

- [x] [OpenAI颠覆世界:GPT-4o完全免费,实时语音视频交互震撼全场,直接进入科幻时代](https://readwise.io/reader/shared/01hxt81n9jscvkcxk48v7wff9a)

- [x] [OpenAI 春季更新:大戏到来前的半代升级](https://readwise.io/reader/shared/01hxx8njqpv2f4tx4r266a6mrk)

- [x] [测试识图](https://mp.weixin.qq.com/s/EBoulSR0wLd-v4LnCgOxrw)