# why

- 决定神经元激活的敏感性和阈值。它不仅决定神经元激活的难易程度,还能在训练过程中更快地收敛。

# what

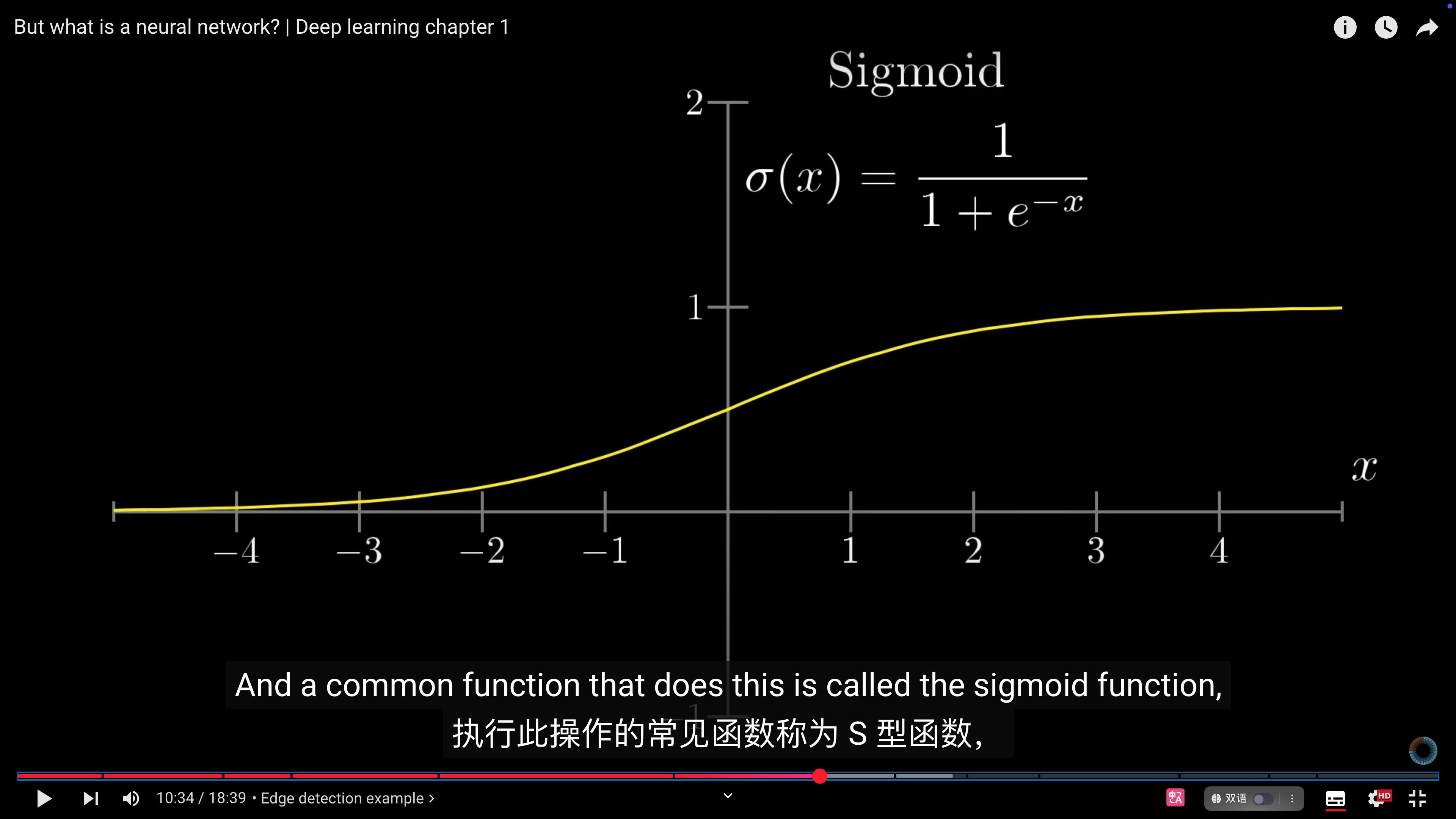

- $neuron(function) = σ(w_1a_1+w_2a_2+w_3a_3+...+w_na_n+b_0) $

- $b_0$为偏差

-

# how

- ### 为什么需要偏差?

- 决定神经元激活的敏感性和阈值。它不仅决定神经元激活的难易程度,还能在训练过程中更快地收敛。

- 决定神经元激活的敏感性和阈值:

- 偏差的作用类似于“阈值”(threshold),它决定神经元被激活时需要的输入水平高低:

- 🌰例子:

- 如果我们希望神经元在加权总和大于10时才激活,可以将偏差$b$设为-10。这样,小于10的值即便经过权重相乘,也不会触发激活。 - $neuron(function) = σ(w_1a_1+w_2a_2+w_3a_3+...+w_na_n-10) $

- 帮助训练更快地收敛

- 偏差的另一个重要作用,是帮助神经网络更灵活、更快地调整自己的决策边界:

- 神经网络训练过程是不断优化权重和偏差以**减少误差**。

- 偏差的存在使得决策边界能够更灵活地上下左右移动,而不仅仅依赖于权重去改变决策边界的角度。

- 在训练过程中,这种“额外自由度”(自由调整的空间)往往能帮助网络更快地找到最优解,从而**更快收敛**。

# how good

- Sigmoid可能导致梯度消失,训练变慢或停滞,因此现代网络更青睐[[ReLU]]。

# Ref.